Die Hamburger Lehr- und Forschungslandschaft bietet ein breites Spektrum an Arbeiten rund um das Thema nextReality aus den Bereichen Virtual Reality (VR), Augmented Reality (AR) oder Mixed Reality (MR) sowie interaktive 360 Grad Videos. In diesem Artikel geben wir Euch einen Überblick über die nextReality-Aktivitäten an der Universität Hamburg (UHH), der Technischen Universität Hamburg-Harburg (TUHH), der Hochschule für Angewandte Wissenschaften (HAW) sowie der HafenCity Universität Hamburg (HCU).

Universität Hamburg

Die Arbeitsgruppe Human-Computer Interaction der Universität Hamburg, unter der Leitung von Prof. Dr. Frank Steinicke, beschäftigt sich mit allen Aspekten der Interaktion zwischen Mensch und Computer in computervermittelten Realitäten, insbesondere aus den Bereichen VR, AR und MR. Die Arbeitsgruppe forscht insbesondere an sogenannten Super-Natural User Interfaces (SNUIs), die auf natürlichen Interaktionsformen wie Laufen, Greifen oder Sprechen basieren, allerdings nicht durch physikalische Einschränkungen der realen Welt limitiert sind.

Das HCI Labor besteht einerseits aus professionellen multimodalen Ausgabegeräten wie einer CAVE, VR und AR HMDs, Projektionsbasierten Systemen, 3D-Monitoren, großformatigen Multitouch-Displays, 3D-Soundanlagen und haptischen Systemen. Darüber hinaus gibt es diverse Eingabegeräte bzw. –Systeme, wie vielfältige kamerabasierte Trackingsysteme (A.R.T. Tracking und OptiTrack Systeme), verschiedene Sensoren zur Erkennung von Gesten und Bewegungen sowie zur Erfassung von Augenbewegungen oder biophysischen Daten.

In unterschiedlichen nationalen und internationalen Projekten arbeitet das Lab mit Experten aus dem Bereich Informatik, Psychologie, Ingenieurwissenschaften, Design und den Neurowissenschaften zusammen.

Im Bereich der Lokomotion wird beispielsweise an der Technik des Redirected Walking in Kooperation mit der Psychologie geforscht. Dabei wird untersucht wie sich Benutzerinnen und Benutzer mit natürlichen Bewegungen in einer virtuellen Welt fortbewegen können, ohne durch die Begrenzungen des realen Raums beschränkt zu sein. So laufen Anwender in der realen Welt auf einer Kreisbahn, während sie in der virtuellen Welt glauben geradeaus zu laufen. Anwendungen finden solche Forschungsarbeiten auch in Kooperation mit dem UKE Hamburg, bei der es um die Therapie von Bewegungsstörungen z.B. bei Parkinson- oder Schlaganfallpatienten geht.

Neben Bewegungen im Raum steht die Interaktion im Raum im Fokus der Arbeitsgruppe.

So werden professionelle und Konsumenten-Trackingsysteme verwendet, um virtuelle Objekte nicht nur virtuell anfassen zu können, sondern sie auch durch haptisches Feedback ganz real zu spüren.

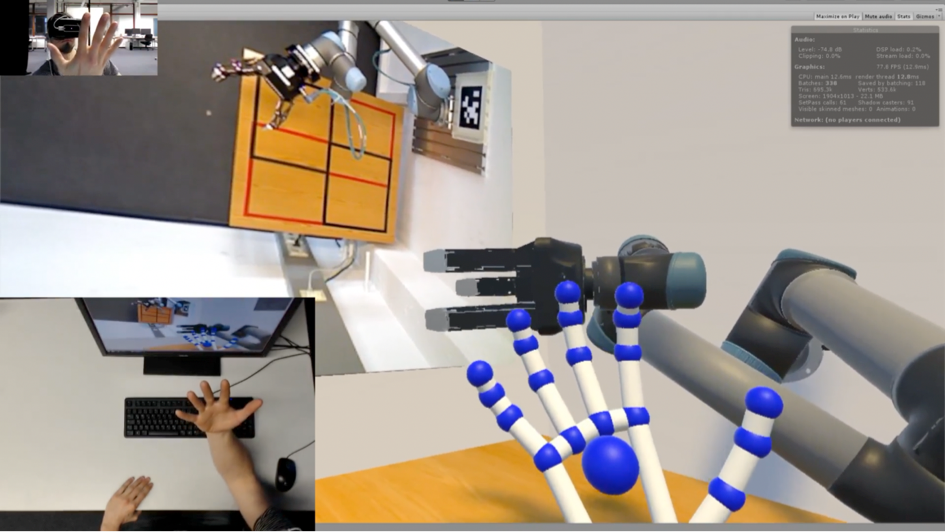

Darüber hinaus forscht die Arbeitsgruppe an der Mensch-Roboter-Interaktion und Telepräsenz. Hier werden in Echtzeit Arm- und Handbewegungen von Menschen auf echte Robotersysteme sowie die Daten von 360°-Kameras der Roboter zurück auf das Head-Mounted-Display (HMDs) des Benutzers übertragen.

Außerdem werden durch 3D-Echtzeitrekonstruktionsverfahren reale Gesprächspartner im Bereich der kollaborativen und sozialen Telepräsenzplattformen realistisch rekonstruiert und über Netzwerk übertragen, so dass auch räumlich getrennte Teilnehmer auf natürliche Art und Weise mit einander kommunizieren können.

Im Rahmen des Bachelor-Studiengangs Mensch-Computer-Interaktion lernen Studierende,

die informatischen und psychologischen Grundlagen, die zur Analyse, Design, Entwicklung und Evaluierung von interaktiven Anwendungen im Kontext von VR- oder AR-Technologien relevant sind.

Hochschule für Angewandte Wissenschaften Hamburg

Die HAW-Hamburg, Fakultät Design, Medien und Information im Department Medientechnik untersucht als einer der Forschungsschwerpunkte die physikalisch korrekte Echtzeit-Lichtsimulation. Beleuchtete Räume mit Licht (Wohnräume, Büros, Gebäude, Event u.a.) können sich sehr viele Menschen, nicht wirklich vorstellen, ohne sie vorher einmal gesehen zu haben.

Um trotzdem die Lichtwirkung vorab korrekt zu visualisieren und kommunizieren gibt es Lichtsimulationsprogramme auf dem Markt, die aber entweder nicht in Echtzeit die physikalisch korrekte Lichtausbreitung berechnen können oder diese lediglich approximieren.

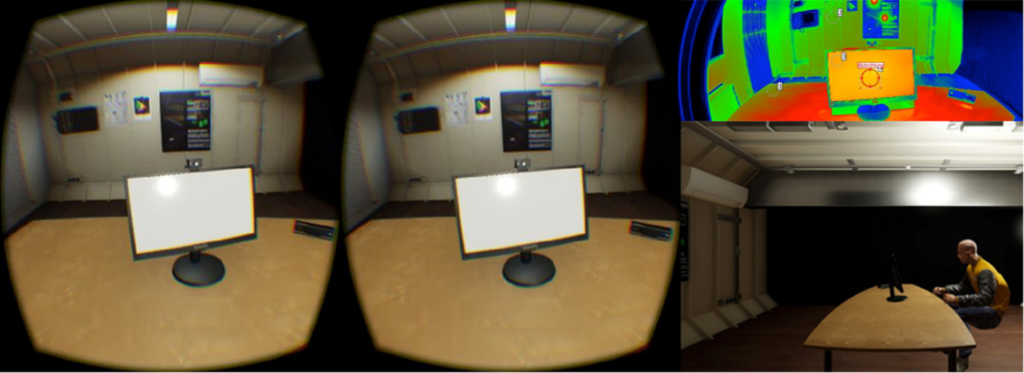

Unter der Leitung von Prof. Dr. Roland Greule wurden in der Game Engine CryEngine korrekte Lichtstärkeverteilungen (LVK) von Leuchten implementiert und eine Pilotstudie zur psychologischen Blendung in Virtual Reality durchgeführt.

Auf dem physikalischen und dem virtuellen Monitor wurde ein Blendreflex erzeugt oder simuliert. Es zeigte sich, dass die virtuelle Blendung in ihrer psychologischen Wirkung im realen und virtuellen Raum von den Probanden ähnlich eingeschätzt wird, was den Schluss nahelegt, dass eine virtuelle Blendungsbewertung mit Head-Mounted-Displays möglich ist.

Diese Erkenntnisse können genutzt werden, um geplante Arbeitsplätze in Zukunft psychologisch blendungsarm zu gestalten, bevor diese überhaupt existieren.

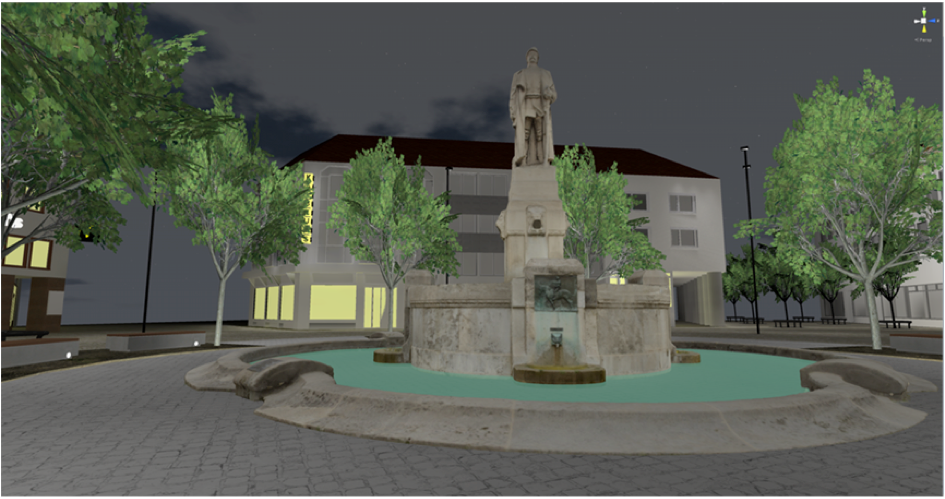

Neben Lichtausbreitung und der Simulation von Blendungseffekten arbeitet die Arbeitsgruppe an der Visualisierung von Außenbeleuchtung mittels VR-Technik, um so eine Vielzahl von Lichtvarianten schnell überprüfen zu können und dadurch aufwendige Bemusterungsprozesse zu minimieren und die Experten-Laien-Kommunikation zwischen Lichtdesignern und Auftraggebern ortsunabhängig zu verbessern.

Ludwigsplatz in Darmstadt nachgebaut mit Game Engine Unity

Neben dem bereits in Hamburg etablierten Gamesmaster-Studiengang M.A. startet ein neuer Masterstudiengang M.Sc. Digital Reality ab dem Sommersemester 2018 im Department Medientechnik. Damit reagiert die Fakultät Design, Medien und Information auf die große Nachfrage der Wirtschaft und Wissenschaft im Bereich der neuen Realitäten.

Der Masterstudiengang ‚Digital Reality‘ ist ein konsekutiver Studiengang, der auf einem Bachelorstudium in Informatik, Media Systems, Medientechnik oder einem gleichwertigen Abschluss aufbaut. Die Regelstudienzeit beträgt vier Semester, wobei das 4. Semester für die Anfertigung der Masterarbeit vorgesehen ist.

Das Labor Creative Place for Technical Innovations (CSTI) an der Hochschule für Angewandte Wissenschaften Hamburg (HAW) ist eine Plattform für angewandte Forschung und Wissenstransfer im Bereich Mensch-Maschine-Interaktion und Smart Systems, ausgehend von der Informatik, methodisch basierend auf interdisziplinären Ansätzen, in Kooperation u.a. mit Mechatronik, Design sowie den Medien- und Kulturwissenschaften.

Die aktuellen Arbeitsschwerpunkte liegen zum einen in interaktiven Installationen und Untersuchungen mit kamerabasierten Gesteninterpretationen insbesondere im Bereich Virtual und Augmented Reality sowie in der Konstruktion von Smart Objects inkl. eingebetteter Systeme und 3D-Drucktechnologien. Das Labor besteht damit einerseits aus einer Rapid Prototype-Linie mit 3D-Scanner, CAD-Systemen sowie mehreren 3D-Druckern.

Andererseits sind mit 3D-Soundanlagen, RGBW-/DMX-Lichtinstallationen sowie diversen kamerabasierten Trackingsystemen wie A.R.T. und Ubisense, VR und AR HMDs und großformatigen Multitouch-Displays die Voraussetzungen vorhanden, um vielfältige Konstruktionen und Untersuchungen in Virtual/ Augmented/ Blended Reality-Anwendungen vornehmen zu können.

Eine im Aufbau befindliche Renderfarm bildet den Kern des VR/AR-Labors, welches ebenfalls Teil des CSTIs ist. Die Aufbauphase des CSTIs (2015 – 2019) wird von der Hamburger Behörde für Wirtschaft, Verkehr und Innovation (BWVI) und vom Zukunftsfond der HAW Hamburg gefördert.

Wahrnehmung in Virtuellen Realitäten: von optischen Täuschungen, Illusionen bis zu unmöglichen Perspektiven (Bachelorarbeit von Jonathan Becker)

Mit der voranschreitenden Entwicklung von Virtual Reality-Anwendungen erhalten immersiv erfahrbare virtuelle Räume eine immer größere Bedeutung.

Damit einher geht auch die Möglichkeit, Räume experimenthaft so zu konstruieren, wie sie in der physikalischen Realität nicht vorkommen können. Zu diesem Zweck wurde für Unity eine modulare Implementierung entwickelt, die Nutzer/innen das freie Bewegen über Wände und Decken in einer VR-Experience ermöglicht. So lassen sich Auswirkungen der Rotation der Perspektive auf die Fähigkeit der Nutzer/innen sich in diesen Räumen zu orientieren und zu bewegen, untersuchen.

Virtual Reality als Plug & Play (Projektarbeit von Gerald Melles und Johann Bronsch)

Das Projekt ist als ‚Spielwiese‘ für Virtual Reality-Interaktionsdesign gedacht. Das primäre Ziel ist die Entwicklung von Adaptern und Arbeitsabläufen, welche die Kombination verschiedener In- und Output-Geräte für VR-Entwickler/innen so einfach wie möglich macht.

Darüber hinaus werden Demonstrationsprototypen für Interaktionstechniken erstellt, einzeln und in diversen Kombinationen. Das aktuelle Demonstrationsszenario ist das Cockpit eines Raumschiffs, dessen Design an ein theoretisches Warpschiff-Design der NASA angelehnt ist, welches sich frei im All navigieren lässt. Der Innenraum ist auf die Freiraumfläche des CSTI abgebildet, die auf ca. 25m² die Bewegungen der Nutzer/innen verfolgen kann.

Hier können Nutzer/innen mit verschiedenen Interaktionstechniken des Schiffs experimentieren und diese erkunden, um durch eine digitale Darstellung unseres Sonnensystems zu reisen. Alle Himmelskörper korrespondieren mit den Originalen in Position und Größe – wenn auch herunterskaliert, um die Navigation zu erleichtern.

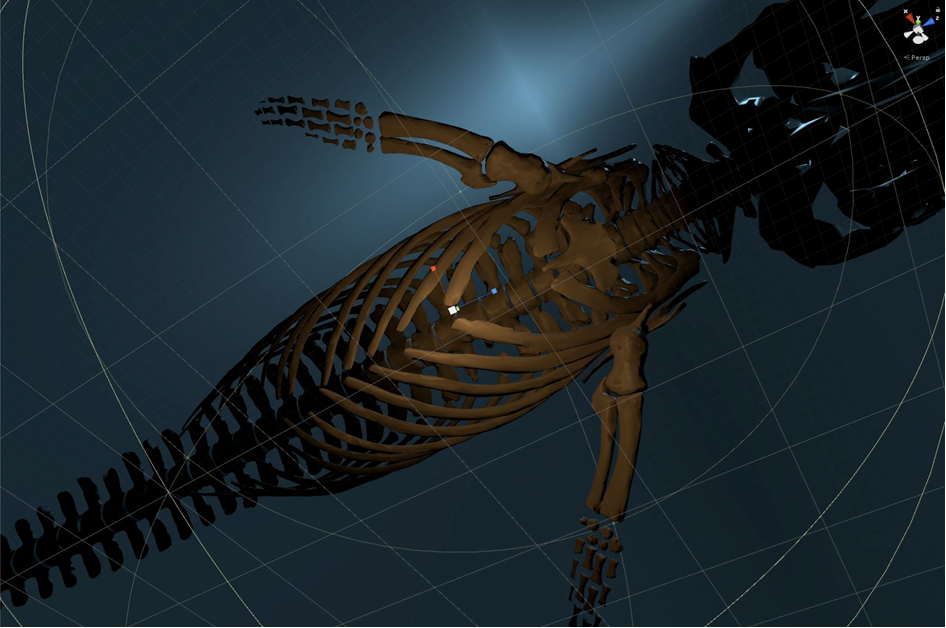

Einen Finnwal in Virtual Reality interaktiv erlebbar machen (Masterprojekt von Ulrike Meyer, in Kooperation mit dem CeNak der Universität Hamburg):

Wie aus reduzierten Scansätzen eines Finnwal-Skeletts immersive, annähernd fotorealistische Darstellungen in einer VR-Installation erzeugt und für Nutzer/innen interaktiv erlebbar gemacht werden können, ist die Fragestellung dieses Projektes.

Die fotorealistische Darstellung von komplexen organischen Oberflächen und Systemen am Beispiel des Walskeletts hat allerdings keine ausschließlich ästhetische Funktion. Details und Oberflächeneigenschaften kommen eine unmittelbare Aussagekraft zu, die auch fehlende haptische Informationen ersetzen kann.

Zur Einbettung der Erfahrung in den jeweiligen Kontext (z.B. das Körperinnere oder eine Unterwasserszene) wird auf quasi-filmische Mittel wie Animation, Ausleuchtung und Compositing zurückgegriffen. Diese vertiefen die Inhalte, verstärken aber auch die räumliche Immersion. Zusätzlich kommen Werkzeuge aus dem Interaction- und Game-Design zum Einsatz, um eine unmittelbare und intuitive Interaktion mit der Umgebung zu ermöglichen.

HafenCity Universität Hamburg

Seit 2014 befasst sich das Labor für Photogrammetrie & Laserscanning der HafenCity Universität Hamburg unter der Leitung von Prof. Thomas Kersten in verschiedenen Projekten und studentischen Abschlussarbeiten zunehmend mit VR und AR. Ein wesentlicher Schwerpunkt liegt im Bereich der 3D-Erfassung und Modellierung von Objekten, insbesondere von Gebäuden, mit verschiedenen optischen Sensoren.

Im Rahmen eines größeren Projektes wurde ein virtuelles Museum des Alt-Segeberger Bürgerhauses mit seinen sechs Bauphasen von 1541 bis heute in der Game Engine Unreal erstellt. Mit HMD kann der Besucher als immersives Erlebnis das Museum in einem interaktiven Rundgang erkunden. Die Navigation durch das virtuelle Museum erfolgt durch eigene freie Bewegung in einem durch das VR-System festgelegten Rahmen oder durch Teleportation mit einem Motion Controller.

In einem weiteren Projekt wurde die Selimiye Moschee in Edirne als immersive und interaktive VR-Anwendung mit der HTC Vive in der Game Engine Unity erstellt. Der Besucher kann die Moschee von Innen und Außen gemeinsam mit mehreren Benutzern betrachten, indem er sich auf dem Boden durch Teleportation oder durch einen Rundflug navigieren kann.

In einem weiteren Projekt wurde die Selimiye Moschee in Edirne als immersive und interaktive VR-Anwendung mit der HTC Vive in der Game Engine Unity erstellt. Der Besucher kann die Moschee von Innen und Außen gemeinsam mit mehreren Benutzern betrachten, indem er sich auf dem Boden durch Teleportation oder durch einen Rundflug navigieren kann.

In Zusammenarbeit mit dem Museum für Hamburgische Geschichte wurde für das Holzmodell des Salomonischen Tempels (Fläche 3.5 m × 3.5 m), welcher in den Jahren 1680 bis 1692 in Form eines zusammensteckbaren Baukastensystems erstellt wurde, dreidimensional aufgenommen, modelliert und zusammen mit den inneren für den Besucher unsichtbaren Räumen für eine VR-Anwendung mit der HTC Vive in den Spiele-Engines Unreal und Unity aufbereitet.

Technische Universität Hamburg-Harburg

Das Institut für Produktionsmanagement und –technik der TUHH, unter der Leitung von Prof. Dr.-Ing. habil. Hermann Lödding, untersucht den Einsatz von VR und AR für alle Phasen des Produktlebenszyklus von Unikaten und in Kleinserien hergestellten Produkten.

Die Anwendungsszenarien stammen vorranging aus dem Schiff- und Flugzeugbau.

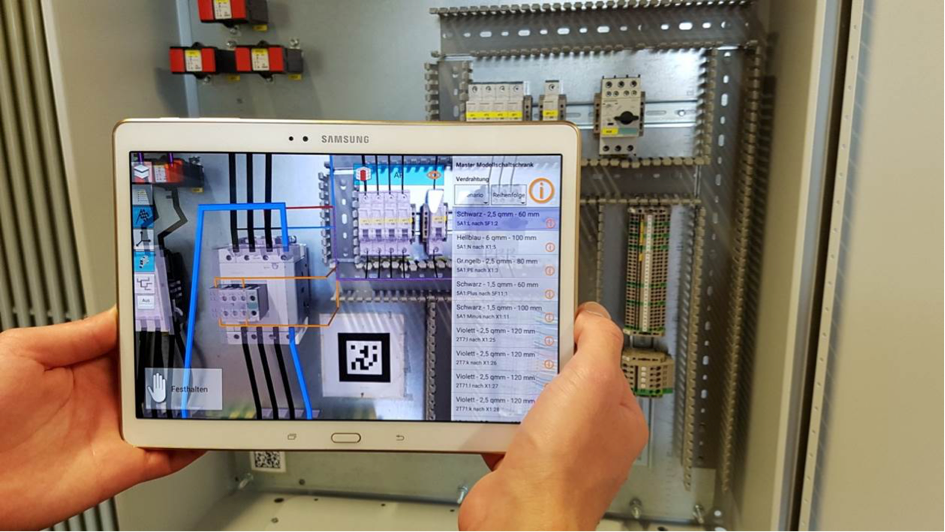

Das Ziel ist dabei, die Produktivität der Prozesse durch den Einsatz virtueller Technologien signifikant zu steigern und durch Messungen vor Ort nachzuweisen. Im Bereich AR wurde dazu eine sogenannte Digitale Arbeitsunterlage entwickelt, die den Werkern einzelne Arbeitsgänge schrittweise einblendet und zusätzliche Rückmeldungen erlaubt. Derzeit wird dieses System zum einen für Wartungsaufgaben und zum anderen zu einer kollaborativen AR-Anwendung im Rahmen von Industrie 4.0 erweitert.

Links:

UHH:

hci.informatik.uni-hamburg.de

https://www.inf.uni-hamburg.de/en/inst/ab/hci/projects.html

https://www.inf.uni-hamburg.de/studies/bachelor/mci.html

HAW:

http://digitalreality.hamburg

http://www.gamesmaster-hamburg.de

HCU:

https://www.hcu-hamburg.de/bachelor/geo/organisation/laphola/

TUHH: